차원의 저주

: 차원이 커지면 커질수록 데이터 포인트들 간 거리가 크게 늘어나므로 데이터가 희소화(Sparse) 되기 시작함

수백~수천 개 이상의 Feature로 구성된 포인트들간 거리에 기반한 머신러닝 알고리즘들이 무력화 됨

또, Feature가 많을 경우, 개별 Feature간 상관관계가 높아 선형 회귀 같은 모델에선 '다중공선성 문제'로 인해 모델의 예측 성능이 저하될 가능성이 매우 높다.

차원 축소 장점

- 학습 데이터 크기를 줄여 학습 시간을 절약할 수 있음

- 불필요한 Feature를 줄여 모델 성능 향상에 기여할 수 있음

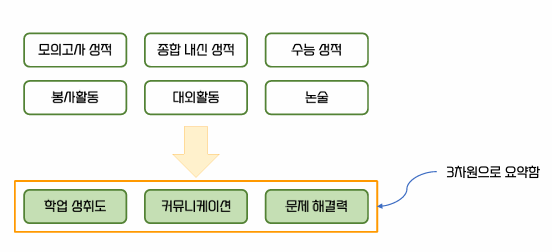

- 다차원 데이터를 3차원 이하의 차원 축소를 통해 시각적으로 쉽게 데이터 패턴을 인지할 수 있음

차원 축소 분류

특성 선택(feature selection)

: 종속성이 강한 불필요한 특성은 완전히 제거하고, 주요 특성만 선택하는 것

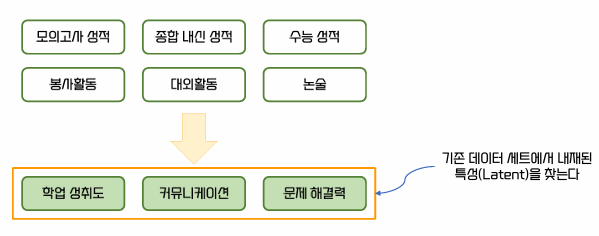

특성 추출(feature extraction)

: 기존 특성을 저차원의 주요 특성으로 압축하여 또 다른 공간으로 매핑해 추출함(*새롭게 추출된 중요 특성은 기존의 특성을 반영해 압축된 것이지만 새로운 특성으로 추출됨)

-> 차원 축소를 통해 데이터를 보다 더 잘 설명할 수 있는 잠재적(Latent)인 요소를 추출함

추천엔진, 이미지 분류 및 변환, 문서 토픽 모델링 등에서 사용됨